L’appréhension par le droit des discriminations algorithmiques

Par Léa Mariani

« The intelligence may be artificial,

but the dangers it poses to our freedom are very real[1] ».

Aux Pays-Bas, un algorithme utilisé par l’administration fiscale s’est appuyé sur des critères discriminatoires, tels que la nationalité, pour détecter les fraudeurs aux allocations familiales. Les personnes désignées par l’algorithme, qui pour 94% d’entre elles étaient innocentes, se sont alors vu demander de rembourser des sommes considérables. En conséquence, des milliers de familles ont sombré dans la pauvreté et au moins un millier d’enfants ont été placés[2].

Crédit photo: Cryptoast, https://cryptoast.fr/la-chine-veut-sappuyer-sur-la-blockchain-pour-son-systeme-de-credit-social/

Cette affaire pose la question des discriminations algorithmiques. Certains auteurs craignent à cet égard que les algorithmes ne facilitent la discrimination intentionnelle. D’autres soulignent toutefois que c’est précisément pour pallier les discriminations des décideurs humains que les institutions se tournent vers les algorithmes. En particulier, les discriminations inconscientes, qui sont les plus nombreuses, risquent moins de se manifester à travers le processus de codage, qui requiert de rédiger des instructions explicites et de documenter l’action du programme, qu’à travers le processus de prise de décision humaine, qui est dénué de telles modalités[3].

En toute hypothèse, il convient de dépasser une vision purement instrumentale des technologies, qui les perçoit comme des outils neutres, pouvant être bien ou mal utilisés, selon le bon vouloir de l’homme[4]. En effet, si les discriminations peuvent provenir de la manière dont l’algorithme est utilisé, elles émanent également du design de l’algorithme ainsi que des données qu’il utilise[5].

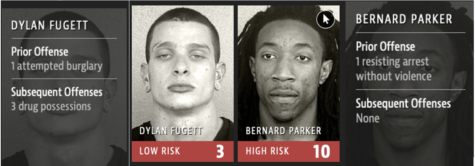

Plus précisément, s’agissant des données, les discriminations peuvent résulter de la sur-représentation, de la sous-représentation ou de la mauvaise représentation de certaines communautés, reproduisant ainsi des biais préexistants[6]. Par ailleurs, les discriminations peuvent résulter de variables de substitution, à l’instar du niveau d’études ou du nombre de proches incarcérés, qui permettent de déduire l’origine ethnique et le niveau social et économique d’une personne[7]. Aux États-Unis, de tels critères permettent ainsi aux algorithmes d’évaluation du risque de récidive d’identifier les personnes noires et de leur attribuer un score de risque de récidive plus élevé que celui des personnes blanches, alors même que la couleur de peau ne fait pas partie des critères pris en compte par le design de l’algorithme[8]. Tout cela renforce alors les inégalités entre groupes privilégiés et marginalisés, tant et si bien que la doctrine évoque de nouveaux modes de profilage racial ou technological redlining[9].

Crédit photo: ProPublica, https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing

En conséquence, il convient de s’interroger sur la manière dont le droit appréhende les discriminations algorithmiques. À cet égard, le droit aspire à une mise en balance des intérêts subjectifs des citoyens et de l’industrie. Hélas, cela aboutit souvent à une protection illusoire des droits humains[10]. En effet, les sociétés fondées sur des systèmes technologiques larges et complexes privilégieraient systématiquement les valeurs de nécessité pratique aux autres valeurs morales, à l’instar de l’égalité et de la justice, perçues comme étant obsolètes, idéalistes et non-pertinentes[11]. La prévalence accordée aux intérêts industriels s’illustre concrètement à travers l’impossibilité d’accéder au fonctionnement des algorithmes au nom de la propriété industrielle. Ainsi, la Cour suprême du Wisconsin a estimé que le recours par un tribunal d’un algorithme d’évaluation des risques, accusé de comporter des biais raciaux, ne violait pas le droit au procès équitable, quand bien même le fonctionnement de l’algorithme n’était révélé ni à la Cour, ni à la défense[12].

Crédit photo :Oxfam, https://frompoverty.oxfam.org.uk/never-heard-of-human-rights-economics-you-have-now/

Crédit photo :Oxfam, https://frompoverty.oxfam.org.uk/never-heard-of-human-rights-economics-you-have-now/

Dès lors, pour lutter contre les discriminations et palier l’opacité des algorithmes, certains auteurs appellent le législateur à imposer davantage de transparence dans leur design[13]. Toutefois, cela serait sans effet sur les discriminations qui résultent non pas de l’algorithme lui-même mais des données qu’il utilise. Pour palier cet écueil, la doctrine propose une transparence des apports, c’est-à-dire des données, et des résultats de l’algorithme[14].

En toute hypothèse, au-delà de la propension du droit à favoriser les libertés économiques, il convient également de souligner l’inadaptation du droit face aux discriminations algorithmiques. En effet, la sanction juridique requiert un certain degré de gravité d’atteinte aux droits humains, et demeure ainsi indifférente à l’accumulation d’atteintes mineures, caractéristique des nouvelles technologies. De plus, l’identification de l’auteur des discriminations algorithmiques et la caractérisation d’une action ou d’une omission sont complexifiées par la dispersion de la prise de décision et ce, d’autant plus à l’ère des algorithmes autoapprenants. Enfin, la règlementation par le droit se heurte à la présomption selon laquelle les objets technologiques seraient neutres, ainsi qu’à un déclin normatif[15].

Il n’en demeure pas moins que le droit demeure un outil pertinent pour lutter contre les discriminations algorithmiques. En effet, son recours est bienvenu pour pallier l’inefficacité des approches autorégulatrices, par exemple incarnées par les cadres éthiques adoptés par les acteurs privés ou les outils d’évaluation imposés par les États. C’est ainsi que l’Union européenne a adopté l’IA Act, qui souligne à plusieurs reprises la nécessité d’assurer le droit à la non-discrimination. Pour ce faire, le recours à l’IA dans des activités dans lesquelles les risques de discrimination sont élevés, à l’instar de l’emploi ou de la répression, est réglementé, par exemple par le biais d’un contrôle humain. L’approche par les risques privilégiée par l’IA Act est toutefois critiquable, car ancrée dans l’inégalité. En particulier, « la différentiation des niveaux de risque ne peut pas tenir compte des situations où les risques sont faibles pour certains mais élevés pour d’autres[16] ». De manière générale, les outils règlementaires seraient incapables de promouvoir l’inclusion, car ils reposeraient sur l’exclusion, en raison de l’absence de participation réelle des citoyens[17].

Il revient donc au droit de relever les défis posés par l’algocratie et de tempérer l’affirmation selon laquelle le cyberespace ne serait pas borné par les frontières étatiques[18].

[1] Conseil de l’Europe, « How to protect ourselves from the dangers of artificial intelligence », https://human-rights-channel.coe.int/ai-fr.html.

[2] Alexia Eychenne, « Aux Pays-Bas, un algorithme discriminatoire a ruiné des milliers de familles », Mediapart, 11 novembre 2022, https://www.mediapart.fr/journal/international/111122/aux-pays-bas-un-algorithme-discriminatoire-ruine-des-milliers-de-familles.

[3]Anupam Chander, « The Racist Algorithm? » (2017) Michigan Law Review Volume 115 Issue 6 p. 1027, https://repository.law.umich.edu/cgi/viewcontent.cgi?article=1657&context=mlr.

[4] Langdon Winner, « Do Artifacts Have Politics », Daedalus , Winter, 1980, Vol. 109, No. 1, Modern Technology: Problem or Opportunity? (Winter, 1980), p. 122, https://www.jstor.org/stable/pdf/20024652.pdf?refreqid=fastly-default%3Abf2089ea56108e29c35c9bff5cfe3add&ab_segments=&origin=&initiator=&acceptTC=1

[5] Humanrights.ch, « Discrimination 2.0: Comment les algorithmes discriminent, et ce que nous devrions faire pour y remédier », 8 février 2024, https://www.humanrights.ch/fr/nouvelles/discrimination-algorithmique-protection#:~:text=Les%20discriminations%20algorithmiques%20peuvent%20se,figure%20pas%20dans%20l’art

[6] Sarit K. Mizrahi, « La cyberjustice et les groupes marginalisés », conférence, Montréal, École d’été 2024 « Cyberjustice et Intelligence artificielle : perspectives juridiques », 6 juin 2024.

[7] Humanrights.ch, « Discrimination 2.0: Comment les algorithmes discriminent, et ce que nous devrions faire pour y remédier », op. cit.

[8] Angwin, Jeff Larson, Surya Mattu and Lauren Kirchner, « Machine Bias », ProPublica, 23 mai 2016, https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing.

[9] Sarit K. Mizrahi, « La cyberjustice et les groupes marginalisés », op. cit.

[10] Karine Gentelet, Sarit K. Mizrahi, « We need concrete protections from artificial intelligence threatening human rights », The Conversation, 26 septembre 2021, https://theconversation.com/we-need-concrete-protections-from-artificial-intelligence-threatening-human-rights-168174.

[11] Langdon Winner, « Do Artifacts Have Politics », op. cit., p. 133.

[12] State v. Loomis, 881 N.W.2d 749, 2016.

[13] Anupam Chander, « The Racist Algorithm? », op. cit., p. 1024.

[14] Ibid, p. 1039-1043.

[15] Hin-Yan Liu, « The Digital Disruption of Human Rights Foundations », Human Rights, Digital Society and the Law: A Research Companion (juin 2019), Chap. 5, p. 79, https://www.researchgate.net/publication/326991445_The_Digital_Disruption_of_Human_Rights_Foundations.

[16] Sarit K. Mizrahi, « La cyberjustice et les groupes marginalisés », op. cit.

[17] Ibid.

[18] John Perry Barlow, « Déclaration d’indépendance du cyberespace », 9 février 1996.

Ce contenu a été mis à jour le 5 novembre 2024 à 11 h 03 min.