Vers une réglementation européenne sur la robotique et l’intelligence artificielle

L’autonomisation, les robots et l’intelligence artificielle (IA) font parties intégrantes de notre société contemporaine, et il est fort à parier que leur impact ne cessera de croitre dans l’avenir. La question de leur encadrement juridique notamment en termes de responsabilité et d’éthique est aujourd’hui au cœur des débats. Aucune disposition légale spécifique n’existe sur ce sujet, si bien que le Parlement européen a décidé de se pencher sur la réglementation de la robotique et de l’IA, invitant ainsi la Commission européenne à élaborer un cadre législatif pour un usage civile des robots.

Au Laboratoire de cyberjustice de l’Université de Montréal, une équipe de jeunes chercheurs a décidé – dans le cadre d’un projet bilatéral Québec/Belgique – de créer un blogue permettant de comprendre l’impact que peut avoir sur le droit, la transition numérique et la robotique. Cet article de blogue portera donc cette fois-ci sur la législation européenne concernant la robotique et l’intelligence artificielle.

Les systèmes d’intelligence artificielle dans notre quotidien

Dans notre vie de tous les jours et dans toutes sortes de contextes, nous entrons sans cesse en interaction avec des robots et d’autres systèmes d’intelligence artificielle. Des technologies en évolution rapide et constante se sont de plus en plus immiscées dans nos vies privée et professionnelle.

Aujourd’hui la plupart des personnes utilisent des téléphones intelligents, des ordinateurs, des tablettes, etc. Les robots collaboratifs ou les systèmes de robots travailleurs opèrent aux côtés des humains. Dans le secteur financier, des algorithmes prennent des décisions sur l’achat et sur la vente d’actions, et ils ont dans une certaine mesure remplacés la nécessité des courtiers. Dans le milieu de la justice, des outils d’IA permettraient de prédire les chances de gagner un procès. Les robots sont partout. Pour autant, ceux qui doivent attirer le plus l’attention sont ceux qui possèdent les capacités d’apprentissage les plus importantes : percevoir ce qui les entoure, adapter leur comportement en fonction d’une situation donnée, apprendre de leur environnement, etc. À ce jour, il n’existe pas de robots autonomes pleinement fonctionnels sur le long terme pour lesquels s’appliqueraient les trois lois de la robotique présentées par Isaac Asimov dans son ouvrage « Cercles vicieux »1, mais on tend à s’en approcher. Or, cette évolution ne va pas sans poser de problèmes, comme le rappel Aïda Ponce Del Castillo.2 « Que se passe-t-il si ces dispositifs se trompent? Un robot peut-il être trainé devant les tribunaux? Que se passe-t-il si une erreur est commise par une voiture automatisée ou par ce robot soignant qui avait semblé si fiable lorsqu’il avait été acheté par votre hôpital local ? Nous savons tous que l’inattendu peut se produire. Qui est responsable en fin de compte : le robot, son propriétaire, le fabricant ? » Ce sont ces réflexions qui ont poussé le Parlement européen à se pencher sur les règles de droit applicables à la robotique et à l’IA, et à adopter le 16 février 2017 la résolution EC/2015/2013 (INL).

La résolution EC/2015/2013 (INL) du Parlement européen en date du 16 février 2017

Fruit des réflexions de l’eurodéputée luxembourgeoise Mady Delvaux-Stehres, la résolution EC/2015/2013 (INL) votée le 16 février 2017 n’est pas la première initiative du Parlement européen consacrée à l’impact de la technologie sur nos sociétés. Déjà en 2009, celui-ci s’était penché sur la régulation des nanotechnologies et des nanomatériaux, poussant la Commission européenne à envisager l’adoption d’un cadre réglementaire.

Aujourd’hui, ce sont les robots et l’intelligence artificielle qui sont dans sa ligne de mire. Ces technologies sont de plus en plus ancrées dans nos vies, que ce soit dans le secteur financier, de la sécurité, ou même de la justice. Le chatbot Procezeus développé au sein du Laboratoire de cyberjustice de l’Université de Montréal en est un parfait exemple. Cet outil d’IA a pour but de comprendre la législation en vigueur en droit du logement, de modéliser le raisonnement juridique d’un décideur, pour répondre aux requêtes effectuées par les divers types d’utilisateurs. La Commission européenne pour l’efficacité de la justice (CEPEJ) est d’ailleurs très investie sur ces questions, celle-ci ayant ouvert une enquête en ligne sur l’utilisation de l’IA dans les systèmes judiciaires auprès des États Membres.

De ce constat, le Parlement européen a décidé de rédiger un rapport présentant une motion de résolution de caractère législatif et comportant des recommandations relatives à des règles de droit civil appliquées à la robotique, dont la Commission européenne serait l’élaboratrice. Cette dernière a d’ailleurs exprimé son intention d’explorer différentes solutions en vue de s’attaquer à la question de la responsabilité et d’établir un registre complet, tout en s’interrogeant sur la question de savoir si une définition de ce qu’est un robot était nécessaire à des fins réglementaires.

Basée sur les résultats du projet FP7 RoboLaw – Regulating Emerging Robotic Technologies in Europe : Robotics facing Law and Ethics, financé par la Commission européenne et mis en œuvre entre 2012 et 2014, la résolution EC/2015/2013 (INL) se fonde également sur l’étude European civil Law Rules in Robotics réalisée à la demande de la commission des affaires juridiques du Parlement européen.

Sur le plan structurel, la résolution s’articule autour de plusieurs sections relatives au développement de la robotique et de l’intelligence artificielle aux seuls usages civils, telles que : les véhicules autonomes, les robots médicaux, les drones, la création d’une agence européenne chargée de la robotique et de l’intelligence artificielle, etc. Les principaux postulats de la résolution sont le droit des personnes au respect de la vie privée, le respect de la fragilité humaine, une transparence maximale raisonnable dans la programmation des systèmes robotiques et la nécessaire prévisibilité du comportement des robots. Sur le plan notionnel, aucune définition commune n’existe actuellement au niveau de l’Union européenne. Cependant le Parlement a demandé à la Commission européenne de proposer une définition « des différentes catégories de systèmes cyber-physiques, de systèmes autonomes et de robots autonomes et intelligents, en prenant en compte les caractéristiques suivantes des robots intelligents :

- Acquisition d’autonomie grâce à des capteurs et/ou à l’échange de données avec l’environnement (interconnectivité); échange et analyse de ces données;

- Capacité d’auto-apprentissage à travers l’expérience et les interactions (critère facultatif);

- Existence d’une enveloppe physique, même réduite;

- Capacité d’adaptation de son comportement et de ses actes à son environnement;

- Non vivant au sens biologique du terme. »

D’autres défis sont également posés à la Commission européenne par le Parlement. En particulier, ce dernier recommande dans sa résolution de créer une personnalité juridique spécifique au robot en tant que « personnalité électronique » avec des droits et des obligations spécifiques, et qui s’appliquerait dans les cas où les robots prennent des décisions ou interagissent avec des tiers, un statut encore inconnu dans la grande majorité (pour ne pas dire la totalité) des systèmes juridiques européens. Le fait que certains robots remplissent des fonctions complexes et délicates comme la gestion d’opérations ou la prise de décisions en temps réel soulève des questions d’ordre juridique. Cependant, leur attribuer la personnalité juridique est impensable à l’heure actuelle. Celle-ci se caractérise par le fait d’avoir des droits et des obligations, ainsi que la capacité de mener une action civile et d’être tenu responsable de ses actes. Une personne juridique est également en mesure d’exprimer des valeurs morales. Une fois que la personnalité est attribuée à des robots ou à d’autres agents artificielles autonomes, ils deviennent des sujets et pénètrent dans l’univers des personnes juridiques.

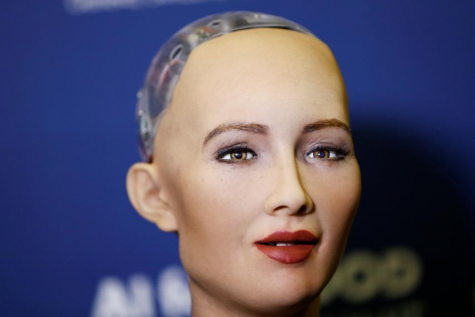

C’est notamment le cas du robot Sophia conçu par la société Hanson Robotics (États-Unis) qui a obtenu le 25 octobre 2017 la citoyenneté saoudienne. Pour autant, celle qui a déclaré vouloir « détruire les humains » peut-elle véritablement être considérée consciente de ces propos au même titre qu’un humain? Les robots pourront-ils savoir qu’ils sont responsables et donc susceptibles de rendre des comptes? La récente affaire des tests sur route d’une voiture autonome d’Uber en Floride ayant conduit à un accident mortel au mois de mars dernier devrait apporter des éléments de réponses sur ces questions.

L’après résolution EC/2015/2013 (INL) : les actions de la Commission européenne

Depuis la résolution du Parlement européen, la Commission européenne s’est penchée sur ces interrogations. Une déclaration commune sur les priorités législatives de l’Union européenne pour 2018-2019 adoptée en décembre 2017 appelle à une protection des données, des droits numériques et des normes éthiques d’un niveau élevé dans le domaine de l’IA et de la robotique.

La Commission a lancé un appel à candidatures qui prendra fin ce lundi 9 avril (pour postuler) pour participer à un groupe d’experts sur l’intelligence artificielle qui sera chargé de :

-

Conseiller la Commission sur le regroupement d’un large éventail de diverses parties prenantes au sein d’une «Alliance européenne pour l’IA»;

-

Soutenir la mise en œuvre de l’initiative européenne sur l’intelligence artificielle prévue prochainement (avril 2018);

-

Présenter d’ici la fin de l’année un projet de lignes directrices pour le développement et l’utilisation éthiques de l’intelligence artificielle sur la base des droits fondamentaux de l’UE. Ce faisant, le groupe prendra en considération des questions telles que l’équité, la sécurité, la transparence, l’avenir du travail, la démocratie et plus généralement l’impact de l’application de la Charte des droits fondamentaux. Ces lignes directrices seront rédigées après une large consultation et partiront de la déclaration faite aujourd’hui par le Groupe européen d’éthique des sciences et des nouvelles technologies (EGE), un organe consultatif indépendant du Président Juncker.

Plusieurs représentants de l’Union européenne saluent d’ailleurs cette démarche tels que :

M. Andrus Ansip, vice-président de la Commission pour le marché unique numérique, a déclaré : « Nous progressons, par étapes, dans la mise en place d’un environnement permettant à l’Europe de tirer le meilleur parti des possibilités offertes par l’intelligence artificielle. Les données, les supercalculateurs et des investissements audacieux sont essentiels pour le développement de l’intelligence artificielle, celle-ci devant faire l’objet d’un large débat public et respecter, aux fins de son utilisation, les principes éthiques. Comme toujours dans l’application des technologies, la confiance est le maître mot.»

Carlos Moedas, commissaire pour la recherche, la science et l’innovation, a ajouté: «L’intelligence artificielle est passée rapidement du stade d’une technologie numérique réservée aux initiés à une technologie générique essentielle très dynamique et apte à créer des marchés. Mais sur quel socle éthique appuyer ces évolutions technologiques? Toute la question est de savoir dans quelle société nous souhaitons vivre. La déclaration d’aujourd’hui jette les bases de notre réponse.»

Mariya Gabriel, commissaire pour l’économie et la société numériques, s’est exprimée en ces termes: « Pour bénéficier de tous les avantages liés à l’intelligence artificielle, cette technologie doit toujours être utilisée dans l’intérêt des citoyens, respecter les normes éthiques les plus élevées, promouvoir les valeurs européennes et préserver les droits fondamentaux. C’est pourquoi nous dialoguons en permanence avec les principales parties prenantes, notamment les chercheurs, fournisseurs, installateurs et utilisateurs de cette technologie. Notre action pour construire le marché unique numérique est essentielle en vue d’encourager le développement et l’adoption des nouvelles technologies.»

Quoi qu’il en soit, les outils d’IA et la robotique se développent à une vitesse considérable. Il est fort à parier que notre tendance actuelle à déléguer des responsabilités à des systèmes artificiellement intelligents deviendra un problème sérieux à l’avenir, d’où l’importance de la résolution du Parlement et des travaux de la Commission. Les conséquences du développement technologique doivent être envisagées en tenant compte des acteurs de la société. Un cadre réglementaire efficace s’impose pour assurer que les agents artificiels coexistent harmonieusement avec les humains, qu’ils soient spécifiquement conçus en fonction des valeurs et des besoins des hommes, et qu’ils opèrent et soient capables de s’adapter en conséquence.

Laura Baudin

Pour en savoir plus

1 « Les trois lois de la robotique sont :

- Un robot ne peut attenter à la sécurité d’un être humain, ni par inaction, permettre qu’un être humain soit mis en danger;

-

Un robot doit obéir aux ordres d’un être humain, sauf si ces ordres entrent en conflit avec la première loi;

-

Un robot doit protéger sa propre existence tant que cela n’entre pas en conflit avec la première ou la deuxième loi. »

2https://www.etui.org/fr/Publications2/Notes-de-prospective/Une-legislation-europeenne-sur-la-robotique-et-l-intelligence-artificielle

Blogue réalisé grâce à la Chaire Lexum.

Ce contenu a été mis à jour le 24 juillet 2018 à 13 h 40 min.